多层感知机(1)-mlp原理

mlp原理

多层感知机,简称mlp,通过在网络中加入一个或多个隐藏层来实现。设矩阵 $\pmb X\in R^{n\times d}$ 表示 $n$ 个小样本,设 $\pmb H\in R^{n\times h}$ 表示有 $h$ 个输出的隐藏层输出,有:

$$

\pmb H=\pmb X\pmb W^{(1)}+b^{(1)}

$$

$$

\pmb O=\pmb H\pmb W^{(2)}+b^{(2)}

$$

设置激活函数 $\sigma$:

$$

\pmb H=\sigma(\pmb X\pmb W^{(1)}+b^{(1)})

$$

$$

\pmb O=\pmb H\pmb W^{(2)}+b^{(2)}

$$

常用的激活函数有 $ReLU,sigmoid$ 等。

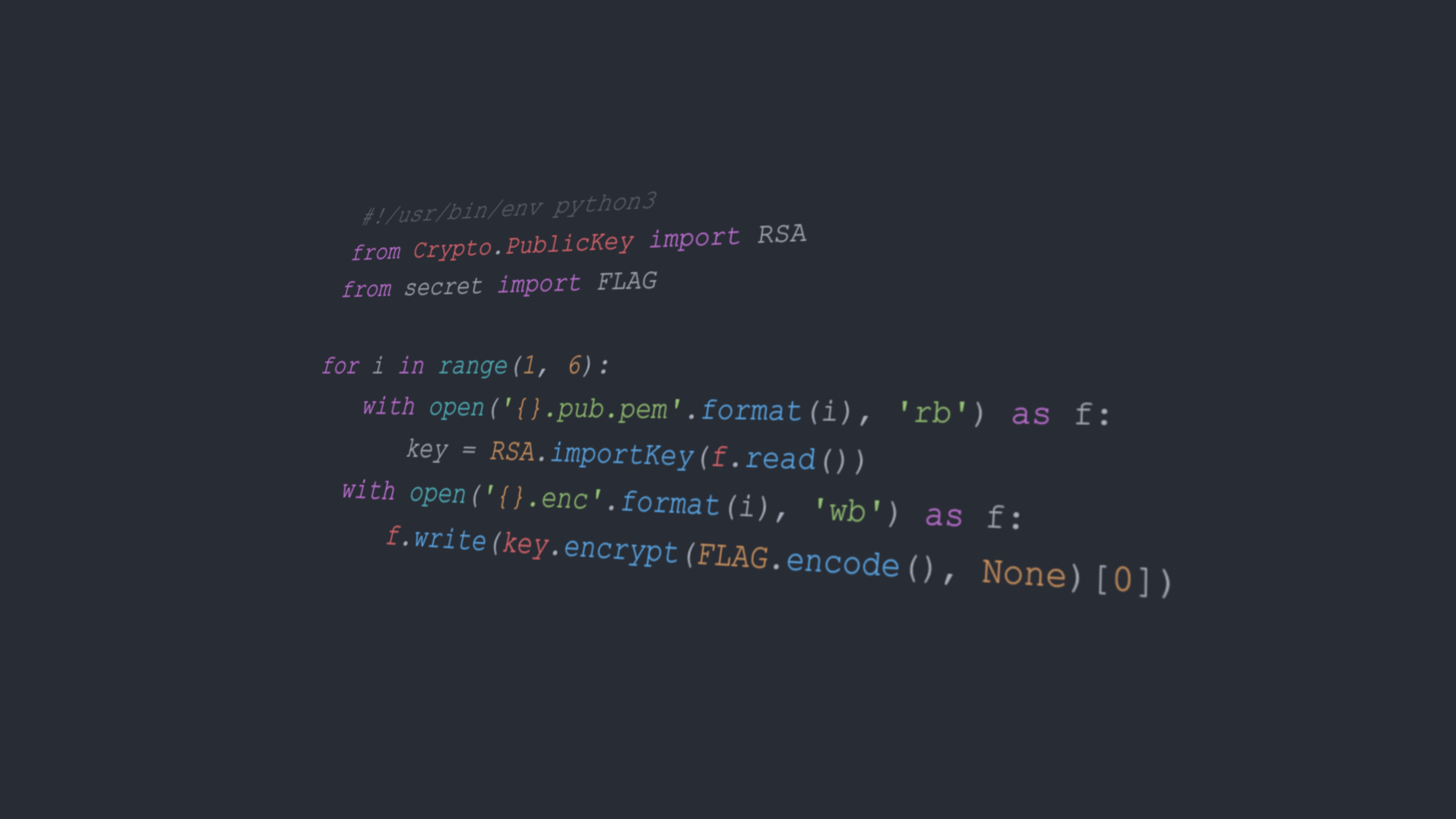

mlp改进softmax回归

在定义模型部分改为:

1 | ###添加输出为256的隐藏层,激活函数为'relu' |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Arn01d's planet!